Néha kell idő, hogy az ember olyan gondolatkísérleteket fusson végig, aminek nincs sok teteje. Mivel pénzügyi témájú városi sétát momentán nem tudunk ajánlani – pedig igény lenne rá! – marad a játék az elméletekkel.

Asimov óta mindenki tudja, hogy a robotoknak meg kell felelni valamilyen törvényeknek. Olyan nincs, hogy nem építünk korlátozást a gépeinkbe. A félelem, hogy a teremtő felé kerekedik a gép valószínűleg egykorú a gépekkel úgy általában.

Természetesen nem minden sci-fi ragaszkodik ehhez az alapvetéshez. És ahhoz sem, hogy a fapados agyú emberiséggel szembe kell fordulnia az okosabb agynak. Iain M. Banks elegánsan megkerülte az egészet a Kultúra-regényekben: a szuperintelligens mesterséges intelligenciák a születésük utáni percekben pattannak meg, pont úgy, ahogy a csevegőrobot a Her című film végén. Az embereknek azok az intelligenciák maradnak, akik nem szuperzseniálisak, de jól érzik magukat ebben a környezetben.

De tegyük fel – mondta Mike Loukides – hogy nem csak három, nehezen programozható robottörvényt akarunk a robotjainkba, hanem teljes etikai rendszereket. Mennyire feldolgozhatók ezek a rendszerek a programozás felől?

Hogy még véletlenül se legyen számon kérhető Loukides először feltételezi, hogy az etikát futtató gépünknek végtelen erőforrások állnak a rendelkezésére. A játéka viszont még így is nagyszerű.

Az utilitarizmus alapelvét John Bentham úgy írta le, hogy az erkölcs és törvénykezés alapja „a lehető legnagyobb boldogságot a lehető legtöbb ember számára”. A szakértő szerint ez optimalizációs problémát feltételez, a Maslow-féle szükségleti piramishoz hasonló modellre van szükség, és ezt kell úgy optimalizálni, hogy a legnagyobb boldogságot érjük el. Akadnak megoldandó problémák: például a hasznosságot definiálni kell, meg kell találni, hogy mit számolunk, és hogy azonos-e ez az érték minden embernél, és hogyan kell összeadni az értékeket. Ráadásul az utilitarizmust használták már etnikai tisztogatás vagy eugenika alátámasztására is, ezt ki kell zárni. De ha a fenti kérdésekre választ találunk, a végtelen erőforrású MI-nk el tudja dönteni a kérdést, a filozófia gépesíthető.

Immanuel Kant kategorikus imperativusa – „cselekedj úgy, hogy akaratod maximája mindenkor egyszersmind általános törvényhozás elveként érvényesülhessen” – is betáplálható lenne egy gépbe, és ez is optimalizálási probléma. Először fel kell mérni, hogy mi történne, ha a teljes populáció azt csinálná, amire az egyén vágyik, majd pedig azt kell ellenőrizni, hogy ez élhető világot eredményez-e. Annyi az eltérés az utilitarizmustól, hogy egy maximum keresése helyett a minimumot akarjuk elkerülni. Ezzel ugyan leegyszerűsítettük Kant érvelését, de nem ez a legnagyobb gond a gondolatkísérlettel.

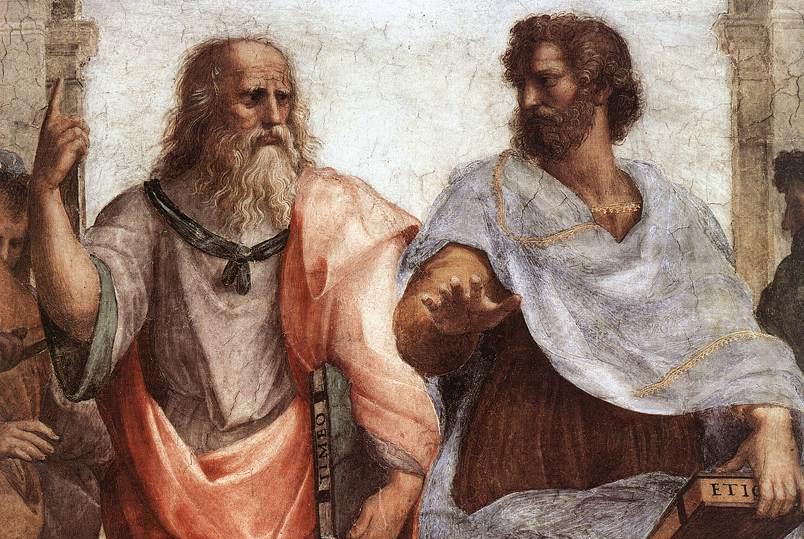

Arisztotelész a legnehezebben programozható

Arisztotelész a következő lépcső, aki szerint a jó mindig két extremitás között található. Az igazságtalanságot látva dühöt kell érezni, de nem annyit, hogy elveszítjük az önkontrollt. A középpont megtalálása dinamikus, egyensúlyozást igényel, ami valójában Loukides szerint egy szabályozási rendszert feltételez visszacsatolással. Ha csak szabályozás, abban remek a számítógép: egy hőmérős termosztát pont ezt a feladatot végzi el a lakásban. Igaz, hőt könnyebb mérni, mint erkölcsi jót. Igen ám, de Arisztotelész sem nagyon árulja el, hogy milyen erényeken alapul az erkölcs, így kicsit nehezebb szenzort rendelni hozzá. Ezen áll vagy bukik az arisztotelészi etika gépesíthetősége: meg tudjuk-e mondani a gép által mérhető módon azt, hogy mi az a jó, erkölcsös, helyes, amitől az ember jól érzi magát.

Végül egy negyedik lehetőséget is felvet a szerző: filozófiai rendszer helyett kereshetnénk olyan mércét, ami alapján eldönthetnénk, jó-e a világ vagy lehet-e optimalizálni rajta. De már a kérdés, hogy ezt a mosolyokból, gesztusokból döntjük-e el, és hogy egyáltalán jól értelmezzük-e azokat, romba dönti az elméletet. És akkor a hosszú távú célok vizsgálatát, mint problémát fel sem vetettük.

Egyelőre a jó megoldás bele se kezdeni

A feltételezett mesterséges intelligencia kereshetné még a Nash-egyensúlyt, amiben az összes játékos a többi sérelme nélküli legjobb eredményt. Ez a megoldás viszont a közösségekkel nem igazán számol, és a filozófus szerint a közlegelők tragédiájaként ismert végállapotba jutunk miatta.

Loukides még kitér az adatbázisokba foglalt elfogultságokra is, hogy biztosan lebeszéljen minden olvasót arról, hogy a Tiszta ész kritikáját kezdje el megírni C++-ban. És még véletlenül se szülessen alig felderített előítéleteket tartalmazó adatok alapján olyan rendszer, ami emberek életére van hatással.

Szólj hozzá